Profitieren vom

KI-Zeitalter

Umfassende Intelligenz für nie dagewesene Ergebnisse

Profitieren vom

KI-Zeitalter

Umfassende Intelligenz für nie dagewesene Ergebnisse

KI ist plötzlich überall ein Thema, aber für Pega war das schon immer Alltag.

Mit unserer KI-gestützten Plattform steckt Entscheidungsfindung im Kern unserer gesamten Arbeit. Deshalb ist es keine Überraschung, dass Pega die ideale Umgebung für sich weiterentwickelnde KI ist, wo Entscheidungen und Workflows im Mittelpunkt stehen – ohne Silos und bereit für jede Lösung. Und die Fachexperten, auf die wir uns verlassen? Die arbeiten alle hier. Hier erfahren Sie, wie sie heute über praktische Anwendungen denken und wie in Zukunft geschäftsfördernde Ergebnisse umgesetzt werden können.

Das Neueste zu KI von unseren Experten

Alan Trefler | Unternehmenstransformation mit KI: Unterstützung für das autonome Unternehmen | PW 25 Keynote

Don Schuerman | Mehr als Widerstandsfähigkeit: Die Unternehmensarchitektur von morgen | PW 25 Keynote

Rob Walker | Die Entwicklung autonomer Unternehmen: Von KI zu ASI und wieder zurück | PW 25 Keynote

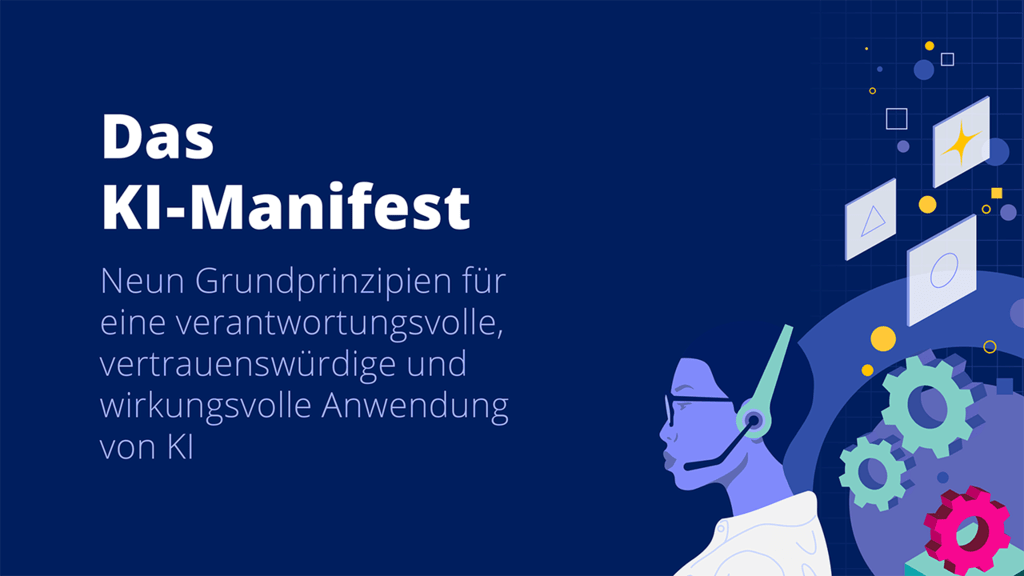

Neun KI-Grundprinzipien

Pega schuf das erste grundlegende KI-Manifest für Unternehmen. Dank dieser Prinzipien blicken Sie hinter den KI-Hype und bringen so effizient echte, geschäftskritische Transformationen voran.

KI für Unternehmen:

Nie dagewesene Innovationen treffen auf Best Practices für ein neues Zeitalter

Wir haben App-Design völlig neu definiert.

Sie haben eine Idee? Setzen Sie sie sofort um!

Optimieren Sie mit unserer leistungsstarken Pega GenAI™ blitzschnell Ihr Workflow-Design. Legen Sie Ihre Vision fest und erleben Sie, wie Ihr Workflow umgehend erstellt wird. Wir haben App-Design völlig neu definiert. Möchten Sie gleich loslegen?

Agentenbasierte KI:

Agenten sind erst der Anfang

KI-Agenten können nicht nur Prompts verarbeiten. Indem Sie Ihre bewährten Workflows in Agenten verwandeln, bleibt die Arbeit konsistent und wird schneller erledigt – alles ohne Kompromisse bei den Unternehmensstandards. Nur Pega integriert agentenbasierte KI in jeden Workflow für echte Enterprise Governance, Vorhersagbarkeit und Transformation.

Verantwortungsvolle KI:

Intelligentere Technologie bedeutet eine

noch größere Verantwortung

KI muss kontrolliert werden und sie kann auf Verantwortungsbewusstsein und Ethik ausgerichtet werden. Wir haben Verantwortungsbewusstsein in unsere Produkte anhand grundlegender Werte integriert: Transparenz, Rechenschaft, Fairness und vor allen Dingen Empathie. Ganz egal, ob sichergestellt wird, dass Ihre KI Entscheidungen mit Echtzeit-Kontext trifft, oder generative KI immer transparent arbeitet – integrierte, menschenbezogene Richtlinien schaffen einen ethischen, verantwortungsvollen Kompass, dem unsere Kunden vertrauen.

Das autonome Unternehmen:

Selbstoptimierung aller Prozesse

Denken Sie an Workflows, die sich ständig selbst optimieren, oder eine Ausnahme, die bereits gelöst wird, bevor sie auftritt. Und jetzt stellen Sie sich das alles maßgeschneidert für Ihr Unternehmen vor. Genau das will das autonome Unternehmen erreichen: ein selbstoptimierendes Geschäft, das KI und Workflow-Automatisierung umfassend für alle Abläufe, Kundeninteraktionen und Touchpoints einsetzt und so eine nie dagewesene Wertschöpfung schafft. Und all das ist schon heute für Sie verfügbar.

KI-Governance und -Sicherheit

Für unternehmensweiten KI-Wert müssen Innovationen mit Verantwortung in Einklang gebracht werden – Governance, Integration und Datenschutz für ethische, transparente und vertrauenswürdige KI. Lesen Sie weiter für hilfreiche Unterstützung von unseren Pega-Experten.

Pega AI Lab

Erfahren Sie mit unseren Vordenkern und Medien mehr zu Innovationen bei KI.

KI-Entscheidungsfindung

Profitieren Sie von KI und treffen Sie

passende Entscheidungen für Ihr Unternehmen.

Machen Sie für jede Next Best Action Selbstoptimierung bei allen Kundeninteraktionen, Serviceabläufen und Workflows möglich.

KI-Entscheidungsfindung

Profitieren Sie von KI und treffen Sie passende Entscheidungen für Ihr Unternehmen.

Machen Sie für jede Next Best Action Selbstoptimierung bei allen Kundeninteraktionen, Serviceabläufen und Workflows möglich.