Saisir

l'opportunité de

l'IA

L'intelligence décuplée, pour des possibilités illimitées

Saisir

l'opportunité de l'IA

L'intelligence décuplée, pour des possibilités illimitées

L'IA semble soudainement omniprésente. Pourtant chez Pega, nous l'avons intégrée depuis toujours.

Notre plateforme est pilotée par l'IA, et l'aide à la décision inclue dans notre ADN. Pega est donc l'environnement idéal pour bénéficier au mieux de l'IA : centré sur les décisions et les workflows, dépourvu de silos et prêt à l'emploi. Les experts de référence dans le domaine travaillent tous dans notre environnement. Découvrez ce qu'ils pensent de sa mise en pratique actuelle, et comment favoriser vos résultats futurs.

Points de vue d'experts sur les dernières innovations de l'IA

Alan Trefler | Transformation de l’entreprise avec l’IA : accélérer le parcours vers l’entreprise autonome | Keynote PW 25

Don Schuerman | Au-delà de la résilience : l'architecture de l'entreprise de demain | Keynote PW 25

Rob Walker | L'évolution de l'entreprise autonome : de l’IA à la superintelligence artificielle | Keynote PW 25

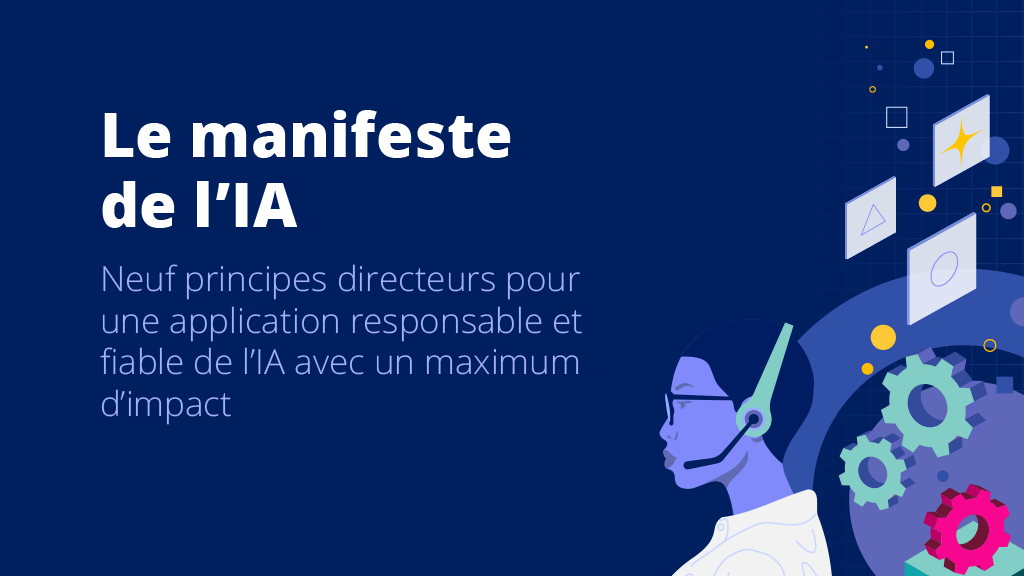

neuf principes directeurs de l'IA

Pega a créé le Manifeste ultime de l'IA pour l'entreprise. Forts de ces principes, vous pourrez voir au-delà de l'engouement autour de l'IA et définir votre propre parcours pour garantir un véritable impact.

L'IA pour l'entreprise :

L'aube d'une nouvelle ère, en alliant l'innovation aux bonnes pratiques

Pega révolutionne la conception d'applications

Une idée ? Construisez-la en un instant.

Optimisez et accélérez la conception de workflow, grâce à la puissance de Pega GenAI™. Présentez votre vision pour générer votre workflow instantanément. Pega révolutionne la conception d'applications Vous êtes prêts ?

IA agentique

Voir plus grand que les agents

Connectez les agents d'IA à plus que des prompts. En transformant vos workflows de confiance en agents, le travail est cohérent et finalisé plus rapidement, tout en respectant les normes de l'entreprise. Seul Pega intègre l'IA agentique à chaque workflow, pour une véritable gouvernance, prévisibilité et transformation dans l'entreprise.

IA responsable :

Un grand pouvoir implique

de plus grandes responsabilités

L'intelligence artificielle nécessite des garde-fous. Mais vous pouvez intégrer la responsabilité et l'éthique dès la conception. La démarche responsable de nos produits s'appuie sur des valeurs essentielles : transparence, responsabilité, équité, et avant tout, empathie. Veiller à ce que les décisions de l'IA s'adaptent au contexte en temps réel, ou encore garantir la transparence à chaque action de l'IA générative, nos garde-fous centrés sur l'humain offrent une véritable boussole éthique, à laquelle nos clients peuvent faire confiance.

L'entreprise autonome :

Tout auto-optimiser

Imaginez des workflows capables de s'accélérer d'eux-mêmes. Ou une exception résolue avant même qu'elle se produise. Et maintenant, imaginez cela à grande échelle. C'est la promesse de l'Entreprise Autonome : une auto-optimisation de toutes les activités, en appliquant des niveaux accrus d'intelligence artificielle et d’automatisation à l'ensemble des opérations, interactions clients et points de contact, pour une valeur ajoutée sans précédent. C'est déjà possible pour vous, maintenant.

Gouvernance et sécurité de l’IA

Apporter la véritable valeur de l’IA dans toute l'entreprise suppose un équilibre entre innovation et responsabilité - le tout en combinant gouvernance, intégration et confidentialité des données pour une IA éthique, transparente et fiable. Lisez la suite pour voir les conseils de notre expert Pega.

Laboratoire d'IA Pega

Apprenez-en plus sur l'innovation de l'IA, à travers nos ressources et avis d'experts.

Décisions basées sur l’IA

Exploitez pleinement la puissance de l'IA,

pour améliorer vos décisions à grande échelle

Prenez systématiquement la meilleure décision, grâce à l'auto-optimisation de chaque interaction client, chaque opération de service et chaque workflow.

Aide à la décision basée sur l’IA

Exploitez pleinement la puissance de l'IA, pour améliorer vos décisions à grande échelle

Prenez systématiquement la meilleure décision, grâce à l'auto-optimisation de chaque interaction client, chaque opération de service et chaque workflow.