Conhecendo o

momento da IA

Utilizando a inteligência para obter resultados ilimitados

Conhecendo o

momento da IA

Utilizando a inteligência para obter resultados ilimitados

Parece que, de repente, a IA está em todos os lugares. Mas aqui na Pega, ela sempre esteve presente.

Por ser uma plataforma baseada em IA, a tomada de decisões está em nosso DNA. Não é de se admirar, portanto, que a Pega seja o ambiente ideal para a IA prosperar - onde as decisões e os fluxos de trabalho estão no cerne. Sem silos. Pronta para resolver. E os especialistas corporativos em quem confiamos? Todos trabalham aqui. Veja como eles pensam sobre a aplicação prática hoje - e como gerar resultados que definirão os negócios no futuro.

Conheça as últimas novidades em IA com nossos especialistas

Alan Trefler | Transformação Empresarial com IA: Impulsionando a Empresa Autônoma | Palestra PW 25

Don Schuerman | Além da Resiliência: Projetando a Empresa do Amanhã | Palestra PW 25

Rob Walker | A evolução empresarial autônoma: da IA à ASI e vice-versa | Palestra PW 25

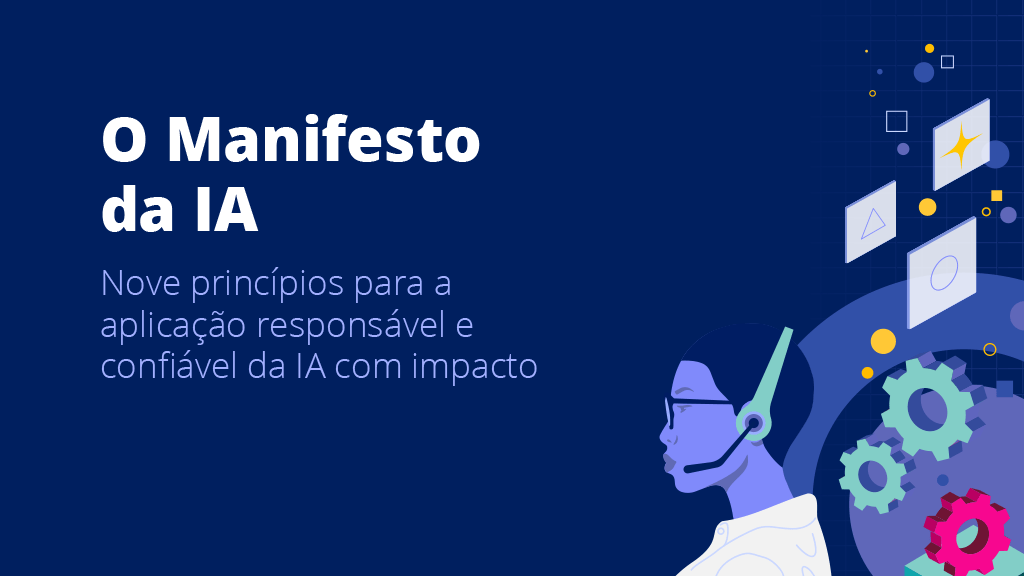

Nove princípios para a aplicação da IA

A Pega criou o manifesto definitivo sobre IA para empresas. Com esses princípios em mãos, você conseguirá ir além do hype da IA e traçar sua jornada para gerar um impacto real e determinante nos negócios.

IA para Empresas:

A inovação sem precedentes se une às melhores práticas para uma nova era

Nós revolucionamos o design de aplicativos

Tem uma ideia? Coloque em prática agora, instantaneamente.

Otimize o design do fluxo de trabalho, rapidamente, com o poder do Pega GenAI™. Defina sua visão e veja seu fluxo de trabalho ser criado instantaneamente. Nós revolucionamos o design de aplicativos. Está pronto?

IA agêntica:

Pense além dos agentes

Conecte os agentes de IA a muito mais do que apenas prompts. Ao transformar seus fluxos de trabalho confiáveis em agentes, o trabalho permanece consistente e é feito mais rapidamente, tudo isso sem comprometer os padrões da empresa. Somente a Pega constrói IA agêntica em cada fluxo de trabalho para uma verdadeira governança, previsibilidade e transformação empresarial.

IA responsável:

Com grandes poderes, vem

maiores responsabilidades

A IA precisa de proteções. Mas você pode desenvolvê-la com responsabilidade e ética. Incorporamos a responsabilidade em nossos produtos com base em valores essenciais: transparência, prestação de contas, justiça e, acima de tudo, empatia. Desde a garantia de que sua IA está tomando decisões com base no contexto em tempo real, até a garantia de transparência em todas as ações da Gen AI, as proteções integradas e focadas no ser humano fornecem uma bússola ética e responsiva na qual nossos clientes confiam.

A empresa autônoma:

Auto-otimize tudo

Imagine fluxos de trabalho que se aceleram por conta própria. Ou uma exceção que é resolvida antes mesmo de acontecer. Agora imagine tudo isso, em escala. Essa é a promessa da empresa autônoma: um negócio auto-otimizado que aplica níveis mais profundos de IA e automação de fluxo de trabalho a cada operação, interação com o cliente e ponto de contato, gerando valor ilimitado. E ela está disponível para você, agora mesmo.

Governança e segurança da IA

A entrega do verdadeiro valor da IA em toda a empresa exige o equilíbrio entre inovação e responsabilidade, combinando governança, integração e privacidade de dados para uma IA ética, transparente e confiável. Continue lendo para obter orientações e conselhos do nosso especialista da Pega.

Pega AI Lab

Saiba mais sobre a inovação em IA com a nossa liderança e mídia consagradas.

Tomada de decisões com IA

Desbloqueie o poder da IA para tomar

decisões melhores, em escala.

Faça com que cada interação com o cliente, operação de serviço e fluxo de trabalho sejam auto-otimizados visando à próxima melhor decisão, sempre.

Tomada de decisões com IA

Desbloqueie o poder da IA para tomar decisões melhores, em escala.

Faça com que cada interação com o cliente, operação de serviço e fluxo de trabalho sejam auto-otimizados visando à próxima melhor decisão, sempre.