Benvenuti

nell'era dell'IA

Un'intelligenza sconfinata per risultati illimitati

Benvenuti

nell'era dell'IA

Un'intelligenza sconfinata per risultati illimitati

Sembra che all'improvviso l'intelligenza artificiale sia ovunque. Ma in Pega è sempre stata qui.

In qualità di piattaforma basata su intelligenza artificiale, il processo decisionale è nel nostro DNA. Quindi non c'è da stupirsi che Pega sia l'ambiente ideale per lo sviluppo dell'intelligenza artificiale, dove le decisioni e i flussi di lavoro sono alla base di tutto. Barriere abbattute. Solution Ready. E gli esperti di livello enterprise a cui ci rivolgiamo? Beh, lavorano tutti qui. Ecco cosa pensano dell'applicazione pratica per il presente e della possibilità di ottenere risultati decisivi per le aziende del futuro.

Scopri le ultime novità in materia di IA dai nostri esperti

Alan Trefler | Trasformazione aziendale con l'IA: potenziare l'azienda autonoma | Intervento PW 25

Don Schuerman | Oltre la resilienza: Architettare l'impresa di domani | Intervento PW 25

Rob Walker | L'evoluzione dell'impresa autonoma: Dall'AI alla super IA e viceversa | Intervento PW 25

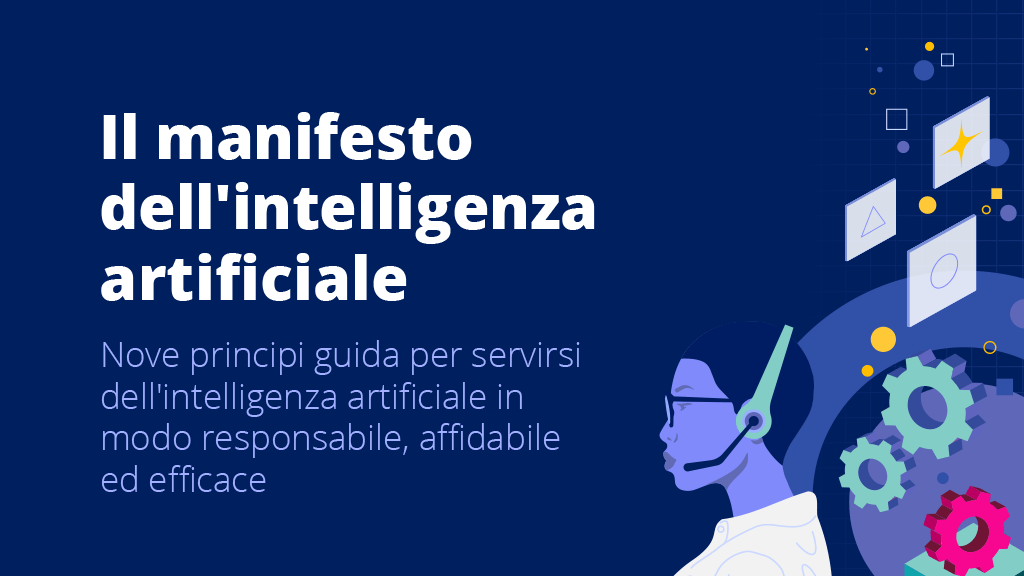

I nove principi guida dell'IA

Pega ha creato il manifesto definitivo sull'IA per le aziende. Grazie a questi principi, riuscirai a superare l'hype dell'IA e a tracciare il tuo percorso e generare un impatto concreto e determinante per l'azienda.

Intelligenza artificiale per l'azienda:

Innovazione senza precedenti e best practice, questa è una nuova era del progresso

Abbiamo rivoluzionato la progettazione delle app

Hai un'idea? Sviluppala subito, all'istante.

Ottimizza la progettazione dei flussi di lavoro, in modo rapido, con la potenza di Pega GenAI™. Imposta la tua visione e assisti alle creazione istantanea del tuo flusso di lavoro. Abbiamo rivoluzionato la progettazione delle app. Cosa aspetti?

IA agentica:

Pensa più in grande degli agenti

Connetti gli agenti di intelligenza artificiale a molto più di semplici prompt. Trasformando i tuoi fidati flussi di lavoro in agenti, il lavoro rimane coerente e può essere fatto più velocemente, il tutto senza compromettere gli standard aziendali. Solo Pega integra l'intelligenza artificiale agentica in ogni flusso di lavoro per ottenere governance, prevedibilità e trasformazione aziendale.

Intelligenza artificiale responsabile:

da un grande potere derivano

grandi responsabilità

All'IA servono soglie di qualità. È opportuno progettare con senso di responsabilità ed etica. Abbiamo integrato nei nostri prodotti dei valori fondamentali: trasparenza, responsabilità, equità e, soprattutto, empatia. Dal garantire che l’IA prenda decisione basate su un contesto in tempo reale all’offrire trasparenza su ogni azione dell’IA generativa, le soglie di qualità integrate e incentrate sull'uomo forniscono una bussola etica adattabile di cui i nostri clienti si fidano.

Impresa autonoma:

ottimizzazione automatica per ogni cosa

Immagina flussi di lavoro che accelerano in autonomia. O un'eccezione che viene risolta prima ancora che si verifichi. Adesso immagina tutto questo, su vasta scala. Questa è la promessa dell'impresa autonoma: un'azienda che si auto-ottimizza e che applica livelli più profondi di IA e di automazione del flusso di lavoro a ogni operazione, interazione con il cliente e punto di contatto, generando valore illimitato. Questa tecnologia è pronta per te, adesso.

Governance e sicurezza dell’IA

Per fornire il vero valore dell'IA a livello aziendale è necessario bilanciare innovazione e responsabilità, combinando governance, integrazione e privacy dei dati per un'IA etica, trasparente e affidabile. Continua a leggere per ricevere indicazioni e consigli dal nostro esperto Pega.

Pega AI Lab

Scopri di più sull'innovazione nell'IA grazie alla nostra leadership ponderata e ai supporti multimediali.

Processo decisionale basato su IA

Sblocca la potenza dell'intelligenza artificiale per arrivare a

decisioni migliori, su vasta scala.

Fai in modo che ogni interazione con il cliente, ogni operazione di servizio e ogni flusso di lavoro si ottimizzino in modo automatico per prendere sempre la decisione migliore.

Processo decisionale basato su IA

Sblocca la potenza dell'intelligenza artificiale per arrivare a decisioni migliori, su vasta scala.

Fai in modo che ogni interazione con il cliente, ogni operazione di servizio e ogni flusso di lavoro si ottimizzino in modo automatico per prendere sempre la decisione migliore.